Anda membutuhkan perangkat keras yang baik untuk proyek AI Anda, tetapi pertama-tama, Anda harus memahami apa itu server AI. Server AI modern memiliki persyaratan yang berbeda untuk setiap tugas AI. Misalnya, model fine-tuning membutuhkan GPU atau TPU yang kuat dengan banyak memori dan jaringan yang cepat. Beban kerja inferensi menggunakan lebih sedikit daya dan membutuhkan latensi rendah serta throughput tinggi, sering kali mengandalkan GPU yang lebih kecil. Setiap tugas AI membutuhkan perangkat keras khusus agar dapat bekerja dengan baik, dan mengetahui apa itu server AI akan membantu Anda memilih pengaturan yang tepat. Saat memilih perangkat keras untuk AI, pikirkan tentang tugas Anda saat ini dan juga rencanakan pertumbuhan AI di masa depan. Untuk benar-benar memahami apa itu server AI, lihatlah bagaimana perangkat keras AI memengaruhi kinerja.

Hal-hal Penting yang Dapat Dipetik

Server AI membutuhkan perangkat keras khusus untuk pekerjaan yang berbeda. Pelatihan membutuhkan GPU yang kuat dan memori yang besar. Inferensi dapat menggunakan GPU yang lebih kecil.

Pilih perangkat keras yang sesuai dengan kebutuhan AI Anda sekarang dan nanti. Skalabilitas memungkinkan Anda meningkatkan suku cadang saat proyek Anda semakin besar.

Penyimpanan cepat, seperti SSD NVMe, sangat penting untuk pekerjaan AI. SSD ini membantu memuat data dengan cepat dan menjaga model Anda tetap bekerja dengan baik.

Kecepatan jaringan penting untuk kinerja AI. Bandwidth yang tinggi diperlukan untuk memindahkan data antara server dan GPU. Hal ini sangat penting dalam pelatihan terdistribusi.

Cobalah untuk tidak membuat kesalahan umum saat memilih perangkat keras AI. Pastikan Anda memiliki memori yang cukup, pendinginan yang baik, dan GPU yang tepat untuk pekerjaan Anda.

Apa yang dimaksud dengan Server AI?

Anda mungkin bertanya-tanya apa itu server ai dan perbedaannya dengan server biasa. Server AI adalah komputer yang dibuat untuk pekerjaan AI yang berat. Pekerjaan ini termasuk melatih model, menjalankan inferensi, dan bekerja dengan banyak data. Menggunakan server ai memberi Anda perangkat keras yang melakukan perhitungan cepat dan memiliki banyak memori. Banyak perusahaan menggunakan server ai khusus untuk proyek-proyek tersulit mereka.

Server AI vs Server Tradisional

Anda mungkin bertanya apa itu server ai dibandingkan dengan server biasa. Server biasa melakukan hal-hal sederhana seperti menyimpan file atau menghosting situs web. Server ini menggunakan CPU biasa dan memori dasar. Server ai memiliki perangkat keras yang lebih baik. Anda sering melihat GPU yang kuat, lebih banyak RAM, dan penyimpanan yang lebih cepat. Hal-hal ini membantu Anda menjalankan pekerjaan ai lebih cepat.

Berikut ini adalah tabel sederhana yang menunjukkan perbedaannya:

Fitur | Server Tradisional | Server AI |

|---|---|---|

CPU | Standar | Performa tinggi |

GPU | Tidak ada atau dasar | Tingkat lanjut, banyak |

RAM | Sedang | Kapasitas besar |

Penyimpanan | HDD/SSD | SSD NVMe |

Kasus Penggunaan | Umum | Beban kerja AI |

Fitur-fitur Utama Server AI

Ketika Anda melihat apa itu server ai, Anda akan melihat hal-hal yang istimewa. Anda mendapatkan dukungan untuk banyak GPU, yang membantu pembelajaran mendalam dan pekerjaan ai lainnya. Anda juga menemukan jaringan cepat, yang memindahkan data dengan cepat di antara komputer. Memori besar memungkinkan Anda melatih model yang lebih besar. Penyimpanan cepat, seperti SSD NVMe, membantu Anda memuat data dengan cepat.

Tip: Jika Anda ingin mengembangkan proyek ai Anda, pilihlah server ai yang dapat Anda tingkatkan. Hal ini membantu Anda mengikuti perkembangan alat ai yang baru.

Sekarang Anda sudah tahu apa itu server ai dan mengapa server ini penting untuk pekerjaan modern. Anda bisa memilih perangkat keras terbaik untuk kebutuhan Anda dan mendapatkan hasil yang lebih baik dari proyek ai Anda.

Tuntutan Beban Kerja AI

Pelatihan, Inferensi, dan Tugas Waktu Nyata

Anda akan melihat bahwa beban kerja AI yang berbeda membutuhkan perangkat keras yang berbeda. Pelatihan adalah proses di mana Anda mengajarkan model AI menggunakan banyak data. Langkah ini menggunakan sumber daya paling banyak. Anda membutuhkan GPU dan CPU yang kuat untuk menangani pelatihan. Inferensi adalah saat Anda menggunakan model AI yang telah dilatih untuk membuat prediksi. Tugas ini menggunakan daya yang lebih kecil daripada pelatihan tetapi masih membutuhkan waktu respons yang cepat. Beban kerja ai waktu nyata, seperti kontrol perintah suara atau navigasi drone, membutuhkan kecepatan dan akurasi. Tugas-tugas ini harus memproses data dengan cepat untuk memberikan hasil yang instan.

Beberapa beban kerja ai yang paling berat meliputi:

Bercak kata kunci

Kontrol perintah suara

Pemrosesan audio dan gambar

Hub sensor

Navigasi dan kontrol drone

Realitas tertambah

Realitas virtual

Peralatan komunikasi

Anda perlu perangkat keras yang efisien untuk menangani beban kerja AI ini. Komputasi berkinerja tinggi dan pemrosesan SIMD membantu Anda menjalankan tugas-tugas ini dengan lancar. Seiring pertumbuhan ai, Anda akan melihat lebih banyak aplikasi yang membutuhkan perangkat keras canggih.

Catatan: Jack Dongarra, seorang Peraih Penghargaan Turing, mengatakan ai sekarang membentuk sebagian besar aplikasi. Anda akan lebih mengandalkan perangkat keras canggih karena beban kerja ai menjadi lebih umum.

Pemrosesan Data dan Kebutuhan Daya

Beban kerja AI modern memindahkan data dalam jumlah besar. Anda membutuhkan penyimpanan yang cepat dan jaringan yang kuat untuk mengimbanginya. Pelatihan dan inferensi keduanya menggunakan kumpulan data yang besar. Beban kerja AI real-time harus memproses data tanpa penundaan. Ini berarti server Anda harus menangani throughput data yang tinggi.

Kebutuhan daya untuk beban kerja ai juga meningkat. Beberapa server ai sekarang menggunakan hampir satu megawatt daya per rak. Sistem daya DC 800V yang lebih baru dapat mendukung hingga 1,2 MW per rak. Sistem 54V yang lebih lama tidak dapat memenuhi tuntutan ini. Anda harus merencanakan untuk kebutuhan daya dan pendinginan yang lebih tinggi saat Anda menyiapkan server ai.

Jika Anda ingin beban kerja ai Anda berjalan dengan baik, Anda harus mencocokkan perangkat keras Anda dengan kebutuhan data dan daya. Hal ini membantu Anda mendapatkan hasil terbaik dari proyek ai Anda.

Persyaratan Perangkat Keras AI Inti

Ketika Anda membuat atau mengubah server AI, Anda perlu mengetahui kebutuhan perangkat keras utama. Kebutuhan ini membantu Anda menjalankan model pembelajaran mendalam dan bekerja dengan data besar. Perangkat keras yang baik memastikan tugas AI Anda bekerja dengan baik dan cepat. Mari kita lihat bagian utama yang Anda butuhkan untuk pekerjaan AI saat ini.

Persyaratan CPU

CPU ibarat otak dari server AI Anda. Anda membutuhkan CPU yang kuat untuk menyiapkan data, menangani memori, dan membantu GPU bekerja sama. Untuk AI, pilihlah CPU dengan banyak core dan kecepatan tinggi. Intel Xeon dan AMD EPYC adalah pilihan yang populer. CPU ini membantu pembelajaran mendalam dan pekerjaan data besar.

Banyak server membutuhkan 12 atau lebih CPU untuk pekerjaan AI. CPU melakukan pekerjaan berat yang tidak dapat dilakukan oleh GPU sendirian. Misalnya, CPU memuat data, menjalankan model pembelajaran mesin yang lama, dan memindahkan info antar bagian. Saat Anda memilih CPU, pastikan CPU tersebut sesuai dengan kebutuhan memori dan GPU Anda.

Tip: Untuk pembelajaran mendalam, pilih CPU dengan setidaknya 16 inti dan memori yang cepat. Hal ini akan menghentikan perlambatan saat Anda melatih atau menggunakan model AI.

Jenis Perangkat Keras | Deskripsi | Performa untuk Tugas AI |

|---|---|---|

CPU | 4-16 pekerja yang sangat cerdas dan serba bisa | Menangani tugas-tugas kompleks secara berurutan |

GPU | 1.000-10.000 pekerja khusus | Bisa 10-100x lebih cepat karena pemrosesan paralel dari operasi matematika sederhana |

Persyaratan GPU

GPU adalah bagian terpenting untuk AI. Anda membutuhkan GPU yang kuat untuk melatih model pembelajaran mendalam dan menjalankan tugas dengan cepat. GPU modern memiliki ribuan inti yang bekerja pada waktu yang sama. Hal ini membuat mereka jauh lebih cepat daripada CPU untuk pekerjaan AI.

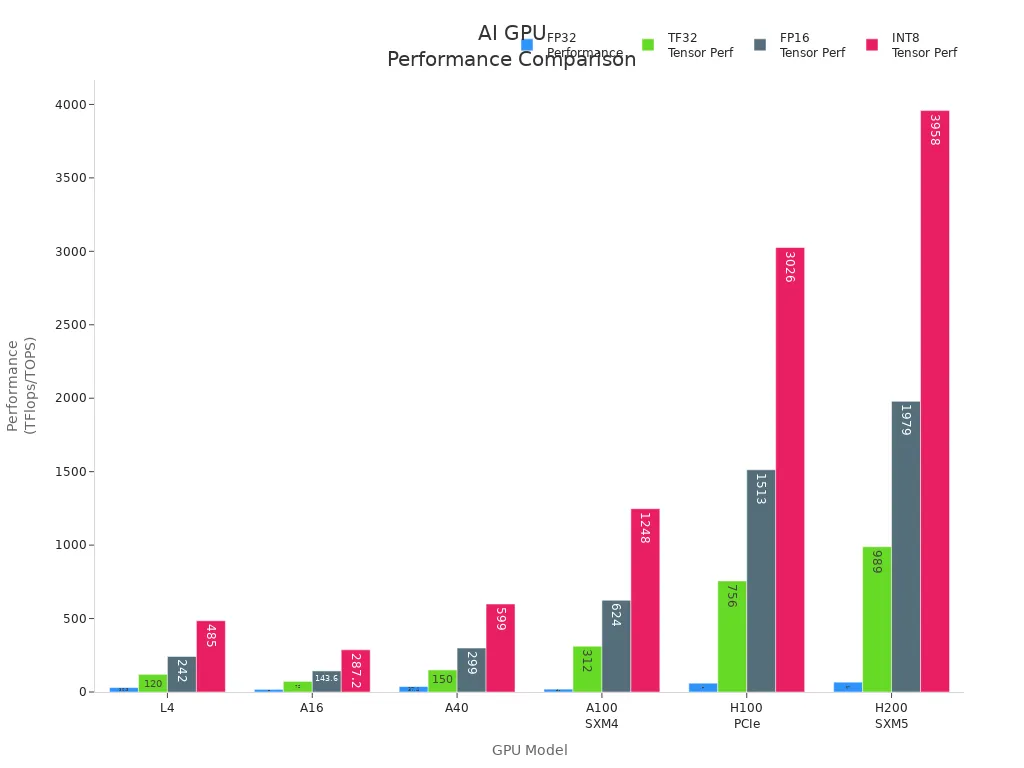

Ketika Anda memilih GPU, carilah model seperti NVIDIA A100, H100, V100, dan L4. GPU ini memiliki banyak memori, kecepatan tinggi, dan performa yang bagus untuk AI. Tabel di bawah ini menunjukkan beberapa GPU terbaik untuk melatih dan menggunakan AI:

Model GPU | Inti CUDA | Inti Tensor | Memori GPU | Throughput Memori | FP32 (TFlops) | TF32 Tensor (TFlops) | FP16 Tensor (TFlops) | INT8 Tensor (TOPS) |

|---|---|---|---|---|---|---|---|---|

L4 | 7,680 | 240 | 24 GB | 300 GB/s | 30.3 | 120* | 242* | 485* |

A16 | 4x 1,280 | 4x 40 | 4x 16 GB | 4x 200 GB/s | 4x 4.5 | 4x 18* | 4x 35.9* | 4x 71.8* |

A40 | 10,752 | 336 | 48 GB | 696 GB/s | 37.4 | 150* | 299* | 599* |

A100 SXM4 | 19,500 | 432 | 80 GB | 1.935 GB/s | 19.5 | 312* | 624* | 1,248* |

H100 PCIe | 60,000 | 528 | 80 GB | 2 TB/s | 60 | 756* | 1,513* | 3,026* |

H200 SXM5 | 72,000 | 528 | 141 GB | 3,3 TB/s | 67 | 989* | 1,979* | 3,958* |

Anda membutuhkan lebih dari satu GPU untuk model AI yang besar dan pembelajaran mendalam. Beberapa server dapat menggunakan hingga delapan GPU. Hal ini memungkinkan Anda melatih model yang lebih besar dan bekerja dengan lebih banyak data sekaligus. GPU juga membantu pekerjaan AI secara real-time seperti tugas gambar dan ucapan.

Catatan: GPU bisa 10 hingga 100 kali lebih cepat daripada CPU untuk pembelajaran mendalam. Selalu pilih GPU yang sesuai dengan kebutuhan AI dan ukuran model Anda.

RAM dan Memori

RAM adalah bagian penting dari perangkat keras AI. Anda membutuhkan memori yang cukup untuk memuat data besar dan menjalankan model deep learning. Jika Anda tidak memiliki RAM yang cukup, pekerjaan AI Anda akan menjadi lambat atau tidak berfungsi.

Untuk pembelajaran mendalam, mulailah dengan setidaknya 768GB RAM DDR4 pada 2667 MHz. Jumlah ini membantu dengan model besar dan pekerjaan data yang cepat. RAM yang lebih besar memungkinkan Anda melatih model yang lebih besar dan melakukan pekerjaan AI yang lebih sulit. Saat model dan data Anda bertambah, Anda membutuhkan lebih banyak memori.

Anda membutuhkan banyak memori untuk pembelajaran yang mendalam.

Lebih banyak RAM menghentikan perlambatan selama pelatihan.

Memori yang cepat membantu pekerjaan AI bekerja lebih baik.

Tip: Selalu periksa kebutuhan memori model AI Anda sebelum berlatih. Tambahkan lebih banyak RAM jika Anda menggunakan model yang lebih besar atau lebih banyak data.

Solusi Penyimpanan

Pekerjaan AI membutuhkan penyimpanan yang cepat dan kuat. Pilih penyimpanan yang dapat menampung data besar dan memberikan akses cepat untuk pembelajaran mendalam. SSD NVMe adalah yang terbaik untuk sebagian besar kebutuhan AI. SSD ini cepat dan merespons dengan cepat.

Berikut ini adalah tabel pilihan penyimpanan teratas untuk AI:

Solusi Penyimpanan | IOPS (Operasi Input/Output Per Detik) | Waktu Tanggapan | Ketersediaan Data | Kapasitas Penyimpanan |

|---|---|---|---|---|

HPE 3PAR StoreServ Storage 8450 | Hingga 3 juta | <1 ms | 99.9999% | Hingga 80 PB |

SSD NVMe 30TB | Performa kecepatan tinggi | N/A | N/A | N/A |

Anda memerlukan penyimpanan yang sesuai dengan kecepatan GPU dan CPU Anda. Penyimpanan yang cepat membantu Anda memuat data dengan cepat dan menjaga model AI Anda bekerja dengan baik. Untuk pekerjaan AI yang besar, gunakan penyimpanan dengan IOPS tinggi dan waktu tunggu yang rendah.

Kebutuhan Jaringan

Jaringan sangat penting untuk perangkat keras AI. Anda membutuhkan bandwidth tinggi untuk memindahkan data di antara server, GPU, dan penyimpanan. Pelatihan AI terdistribusi membutuhkan jaringan yang cepat dan kuat agar semuanya dapat bekerja sama.

Server GPU memberikan bandwidth tinggi dan fleksibilitas untuk pelatihan AI terdistribusi.

Anda membutuhkan setidaknya jaringan 100Gb untuk pekerjaan AI yang besar.

Cluster yang dekat dengan tim Anda membantu dengan data dan kinerja.

Fitur | Deskripsi |

|---|---|

Jenis Server | Server GPU menyediakan bandwidth tinggi dan fleksibilitas untuk pelatihan AI terdistribusi. |

Akselerasi Beban Kerja | Ideal untuk melatih model bahasa yang besar dan menangani analisis data yang besar. |

Kinerja | Menjamin kinerja optimal dan keandalan tinggi untuk berbagai aplikasi. |

Catatan: Selalu sesuaikan kecepatan jaringan Anda dengan kebutuhan perangkat keras AI Anda. Jaringan yang lambat dapat membuat model pembelajaran mendalam dan pekerjaan AI menjadi lebih lama.

Perangkat Keras AI Serbaguna vs. Perangkat Keras AI Khusus

Anda dapat memilih CPU umum atau perangkat keras AI khusus seperti TPU dan FPGA. CPU melakukan banyak pekerjaan, tetapi GPU, TPU, dan FPGA bekerja lebih cepat untuk pembelajaran mendalam.

CPU: Baik untuk menyiapkan data dan model lama.

GPU: Terbaik untuk pembelajaran mendalam dan mengerjakan banyak hal sekaligus.

TPU: Dibuat untuk pekerjaan AI, terutama pembelajaran mendalam.

FPGA: Fleksibel dan bagus untuk pekerjaan AI khusus.

Perangkat keras AI khusus seperti TPU dan FPGA dapat membuat pekerjaan menjadi lebih cepat dan menggunakan lebih sedikit daya. Anda harus mempertimbangkan hal ini jika pekerjaan AI Anda membutuhkan kecepatan yang lebih tinggi atau efisiensi yang lebih baik.

Tip: Selalu periksa kebutuhan perangkat keras AI Anda sebelum memilih perangkat keras umum atau khusus. Pilihan terbaik tergantung pada model, data, dan seberapa cepat Anda perlu bekerja.

Dengan mengetahui kebutuhan perangkat keras AI utama ini, Anda dapat membangun server yang sesuai dengan pekerjaan deep learning dan AI Anda. Perangkat keras yang baik membantu Anda melatih model yang lebih besar, menggunakan lebih banyak data, dan mendapatkan hasil yang lebih baik untuk semua tugas AI Anda.

Spesifikasi Perangkat Keras Minimum dan yang Direkomendasikan

Memilih perangkat keras yang tepat membantu model ai Anda bekerja dengan baik. Anda harus mencocokkan perangkat keras Anda dengan tugas-tugas AI Anda. Setiap pekerjaan membutuhkan cpu, gpu, memori, ram, dan penyimpanan yang berbeda. Berikut adalah aturan mudah untuk pelatihan, inferensi, dan AI waktu nyata.

Untuk Pelatihan AI

Melatih model AI menggunakan banyak sumber daya. Anda membutuhkan perangkat keras yang kuat untuk dataset besar dan model yang sulit. Pengaturan yang tepat memungkinkan Anda berlatih lebih cepat dan melakukan pekerjaan ai yang lebih besar.

Persyaratan minimum untuk pelatihan ai:

cpu: 16 inti (Intel Xeon atau AMD EPYC)

gpu: 1 NVIDIA A100 atau V100

Ram: 256GB DDR4

memori: 256GB atau lebih

penyimpanan: SSD NVMe 2TB

Jaringan: 25Gbps

Persyaratan yang disarankan untuk pelatihan ai:

cpu: 32+ inti (Intel Xeon atau AMD EPYC terbaru)

gpu: 4-8 NVIDIA H100 atau A100

ram: 768GB DDR4 atau lebih tinggi

memori: 768GB atau lebih

penyimpanan: 8TB + SSD NVMe

Jaringan: 100Gbps atau lebih tinggi

Tip: Daya gpu dan ram yang lebih besar membantu Anda melatih model yang lebih besar. Anda dapat menyelesaikan pekerjaan dengan lebih cepat. Selalu periksa ukuran model Anda sebelum berlatih.

Anda membutuhkan kartu gpu yang kuat karena kartu ini melakukan banyak tugas sekaligus. Ram dan memori yang lebih besar memungkinkan Anda memuat set data besar dengan cepat. Penyimpanan yang cepat membuat data Anda terus bergerak selama pelatihan.

Untuk Inferensi AI

Inferensi menggunakan model yang telah dilatih untuk membuat prediksi. Anda membutuhkan perangkat keras yang memberikan hasil cepat dan menangani banyak permintaan. Pengaturan yang tepat membantu Anda mendapatkan kinerja yang baik dan penundaan yang rendah untuk pekerjaan AI Anda.

Persyaratan minimum untuk inferensi ai:

cpu: 8 inti (Intel Xeon atau AMD EPYC)

gpu: 1 NVIDIA L4 atau A16

Ram: 64GB DDR4

memori: 64GB atau lebih

penyimpanan: SSD NVMe 1TB

Jaringan: 10Gbps

Persyaratan yang direkomendasikan untuk inferensi ai:

Memori | Kasus Penggunaan | |

|---|---|---|

NVIDIA B200 | 180 GB | Beban kerja memori tinggi |

NVIDIA DGX B200 | 1440 GB | LLM sumber terbuka yang besar |

Node Multi-GPU | N/A | Inferensi terdistribusi |

cpu: 16+ inti (Intel Xeon atau AMD EPYC terbaru)

gpu: NVIDIA B200 atau DGX B200 (untuk model besar)

Ram: 256GB DDR4 atau lebih tinggi

memori: 256GB atau lebih

penyimpanan: SSD NVMe 4TB

Jaringan: 25Gbps atau lebih tinggi

Catatan: Inferensi pada cpu lambat. Anda mungkin hanya mendapatkan beberapa karakter setiap beberapa detik. Kartu gpu modern dapat memberikan lebih dari 100 karakter setiap detiknya. Untuk hasil terbaik, simpan seluruh bobot model Anda dalam memori gpu.

Anda mendapatkan hasil yang lebih baik dengan satu node multi-gpu untuk inferensi. Pengaturan ini menurunkan penundaan dan membuat pekerjaan AI Anda tetap sederhana. Menggunakan banyak node untuk inferensi dapat memperlambat Anda dan membutuhkan biaya lebih banyak.

Untuk AI Waktu Nyata

Pekerjaan AI real-time membutuhkan jawaban instan. Anda harus menggunakan perangkat keras yang memberikan kecepatan tinggi dan penundaan yang rendah. Aturan ini membantu Anda menjalankan model AI untuk kontrol suara, navigasi drone, dan augmented reality.

Persyaratan minimum untuk ai waktu nyata:

cpu: 8 inti (Intel Xeon atau AMD EPYC)

gpu: 1 NVIDIA L4 atau A16

Ram: 64GB DDR4

memori: 64GB atau lebih

penyimpanan: SSD NVMe 1TB

Jaringan: 10Gbps

Persyaratan yang disarankan untuk ai waktu nyata:

cpu: 16+ inti (Intel Xeon atau AMD EPYC terbaru)

gpu: 2-4 NVIDIA A100 atau H100

Ram: 256GB DDR4 atau lebih tinggi

memori: 256GB atau lebih

penyimpanan: SSD NVMe 2TB

Jaringan: 25Gbps atau lebih tinggi

Tip: AI real-time membutuhkan kartu gpu yang cepat dan ram yang cukup. Selalu uji perangkat keras Anda dengan pekerjaan AI yang sebenarnya sebelum Anda tayangkan.

Anda harus menyeimbangkan cpu, gpu, memori, dan penyimpanan untuk hasil terbaik. Jaringan yang cepat membantu pekerjaan AI Anda berjalan dengan lancar, terutama dengan banyak kartu gpu.

Jika Anda mengikuti aturan-aturan ini, Anda dapat membangun server ai untuk pelatihan, inferensi, dan ai real-time. Perangkat keras yang tepat memberi Anda kecepatan yang lebih baik, hasil yang lebih cepat, dan model ai yang lebih andal.

Membandingkan Kebutuhan Perangkat Keras AI berdasarkan Tugas

Pelatihan vs Penyimpulan

Anda perlu memahami bagaimana perubahan perangkat keras ketika Anda beralih antara pelatihan dan inferensi untuk model ai. Pelatihan mendorong server Anda ke batasnya. Anda menggunakan banyak kartu gpu, sering kali delapan atau lebih, seperti NVIDIA H100, untuk menangani data dalam jumlah besar. Cpu harus memiliki banyak core untuk mengimbangi gpu dan memindahkan data dengan cepat. Pelatihan juga membutuhkan banyak memori. Anda menginginkan bandwidth memori yang tinggi agar model Anda tidak melambat.

Inferensi bekerja secara berbeda. Anda menggunakan lebih sedikit kartu gpu, terkadang hanya satu atau dua. Anda dapat menjalankan inferensi pada cpu, tetapi Anda mendapatkan kinerja yang jauh lebih baik dengan gpu. Cpu tidak membutuhkan banyak core untuk inferensi. Anda masih membutuhkan performa yang baik, tetapi perangkat keras tidak bekerja sekeras saat pelatihan. Memori memang penting, tetapi Anda tidak membutuhkannya sebanyak yang Anda butuhkan untuk pelatihan.

Berikut ini adalah perbandingan singkatnya:

Tugas | GPU Dibutuhkan | CPU Dibutuhkan | Memori yang Dibutuhkan | Fokus Kinerja |

|---|---|---|---|---|

Pelatihan | Banyak inti | Sangat tinggi | Kecepatan maksimum | |

Kesimpulan | 1-4 kartu atau CPU | Lebih sedikit inti | Sedang | Respon cepat |

Tip: Jika Anda ingin melatih model ai besar, berinvestasilah dalam lebih banyak kartu gpu dan memori tinggi. Untuk inferensi, fokuslah pada performa cepat dengan kartu gpu yang lebih sedikit.

Pemrosesan Waktu Nyata vs Pemrosesan Batch

Tugas AI real-time membutuhkan jawaban instan. Anda menggunakan perangkat keras yang memberikan kinerja cepat dan penundaan yang rendah. GPU harus memproses data dengan cepat. CPU membantu memindahkan data tanpa menunggu. Anda menginginkan memori yang cukup agar model Anda berjalan dengan lancar. Pekerjaan waktu nyata mencakup kontrol suara dan navigasi drone.

Pemrosesan batch bekerja dengan sekelompok besar data sekaligus. Anda tidak membutuhkan hasil yang instan. Anda dapat menggunakan lebih banyak inti cpu dan kartu gpu untuk menyelesaikan pekerjaan besar dari waktu ke waktu. Performa memang penting, tetapi Anda dapat menunggu lebih lama untuk mendapatkan hasil. Anda membutuhkan memori yang cukup untuk menangani semua model dan data Anda.

Waktu nyata: GPU cepat, cpu cepat, penundaan rendah, performa stabil.

Batch: Lebih banyak kartu gpu, lebih banyak inti cpu, memori tinggi, waktu pemrosesan lebih lama.

Catatan: Pilih perangkat keras Anda berdasarkan tugas AI Anda. Pekerjaan real-time membutuhkan kecepatan. Pekerjaan batch membutuhkan daya dan memori.

Mengoptimalkan dan Menghadapi Masa Depan Perangkat Keras Server AI

Skalabilitas dan Peningkatan

Anda ingin server ai Anda tumbuh seiring dengan perubahan kebutuhan Anda. Skalabilitas berarti Anda dapat menambahkan lebih banyak daya di kemudian hari. Anda dapat memulai dengan beberapa GPU dan menambahkan lebih banyak lagi ketika model Anda semakin besar. Banyak server yang memungkinkan Anda meng-upgrade CPU, memori, dan penyimpanan. Hal ini membuat perangkat keras Anda siap untuk pekerjaan AI yang baru. Saat merencanakan peningkatan, periksa apakah Anda dapat menambahkan TPU atau lebih banyak GPU dengan mudah. Beberapa server ai dapat menggunakan hingga delapan GPU atau TPU. Hal ini membantu Anda melatih model dengan lebih cepat. Anda harus melihat apakah server Anda dapat menangani lebih banyak memori dan jaringan yang lebih cepat. Skalabilitas berarti Anda tidak memerlukan server baru setiap kali pekerjaan ai Anda berkembang.

Energi dan Pendinginan

Server ai berkinerja tinggi menggunakan banyak energi. Anda membutuhkan pendinginan yang baik untuk menjaga keamanan perangkat keras Anda. Ada beberapa cara untuk mendinginkan server ai. Pendinginan langsung ke chip menempatkan pelat dingin pada CPU dan GPU. Hal ini membantu mengontrol panas dengan lebih baik. Sistem liquid-to-air berfungsi untuk pekerjaan ai menengah tetapi mungkin tidak cocok untuk pengaturan yang ramai. Pendinginan imersi menempatkan server dalam cairan khusus untuk memindahkan panas. Pendinginan imersi dua fase menggunakan cairan mendidih dan kondensasi untuk hasil terbaik. Setiap metode pendinginan memiliki kelebihan dan kekurangan. Anda dapat melihat perbedaannya pada tabel di bawah ini:

Metode Pendinginan | Deskripsi | Keuntungan | Keterbatasan |

|---|---|---|---|

Sistem cairan-ke-udara | Lingkaran pendingin tertutup di dalam rak, memindahkan panas ke udara. | Mudah diatur, bagus untuk pekerjaan menengah. | Tidak bagus untuk server yang sangat sibuk, tidak mudah untuk berkembang. |

Pendinginan langsung ke chip | Pelat dingin menyentuh CPU/GPU untuk kontrol panas yang lebih baik. | Berfungsi dengan baik, terbaik untuk server yang kuat. | Membutuhkan lebih banyak pipa dan pengaturan. |

Pendinginan perendaman fase tunggal | Server berada di dalam cairan khusus untuk transfer panas yang merata. | Kontrol panas yang hebat, tidak berisik, tidak perlu kipas server. | Membutuhkan perangkat keras khusus, membutuhkan lebih banyak ruang. |

Pendinginan perendaman dua fase | Menggunakan cairan mendidih dan kondensasi untuk memindahkan panas. | Sangat bagus dalam hal pendinginan, sebagian besar bekerja dengan sendirinya. | Cairan sangat mahal, sulit untuk diatur dan dirawat. |

Pilih metode pendinginan yang sesuai dengan ukuran server ai Anda dan seberapa sibuknya server tersebut. Pendinginan yang baik membuat TPU dan GPU Anda tetap bekerja dengan cepat.

Mempersiapkan Kebutuhan AI di Masa Depan

Anda harus merencanakan terlebih dahulu saat membangun server AI Anda. TPU dan FPGA lebih banyak digunakan untuk pembelajaran mendalam sekarang. TPU bekerja dengan cepat dan menggunakan lebih sedikit energi untuk pelatihan. FPGA memungkinkan Anda mengubah perangkat keras Anda untuk pekerjaan AI khusus. Anda dapat menggunakan TPU, GPU, dan CPU secara bersamaan untuk hasil terbaik. Model AI baru membutuhkan lebih banyak memori dan jaringan yang lebih cepat. Pilih server yang memungkinkan Anda meningkatkannya nanti. Dengan cara ini, Anda dapat menambahkan lebih banyak TPU atau memori saat proyek ai Anda berkembang. Merencanakan masa depan membantu Anda tetap siap untuk alat baru dan pekerjaan yang lebih besar.

Tip: Selalu uji perangkat keras ai Anda dengan pekerjaan nyata sebelum Anda meningkatkan. Hal ini akan membantu Anda menemukan perpaduan TPU, GPU, dan CPU terbaik untuk pekerjaan Anda.

Tips Praktis untuk Memilih Perangkat Keras Server AI

Menilai Kebutuhan Anda

Anda harus mulai dengan melihat beban kerja ai Anda. Pikirkan tentang ukuran data Anda dan kecepatan yang Anda inginkan. Jika Anda melatih model yang besar, Anda memerlukan GPU yang kuat dan memori yang banyak. Untuk tugas AI yang sederhana, Anda dapat menggunakan lebih sedikit sumber daya. Tuliskan tujuan Anda dan jenis proyek AI yang Anda rencanakan untuk dijalankan. Hal ini akan membantu Anda memilih perangkat keras yang sesuai dengan kebutuhan Anda.

Buatlah daftar tugas-tugas utama Anda.

Periksa apakah Anda memerlukan hasil waktu nyata atau pemrosesan batch.

Perkirakan berapa banyak data yang akan Anda gunakan setiap bulannya.

Tentukan apakah Anda ingin meningkatkan server Anda di masa mendatang.

Tip: Uji model ai Anda pada perangkat keras kecil terlebih dahulu. Anda bisa melihat mana yang paling cocok sebelum membeli server yang lebih besar.

Menghindari Kesalahan Umum

Banyak orang melakukan kesalahan saat memilih perangkat keras server. Anda mungkin membeli memori yang terlalu kecil atau memilih GPU yang tidak sesuai dengan beban kerja Anda. Beberapa orang melupakan kebutuhan pendinginan dan daya. Yang lain tidak merencanakan pertumbuhan ai di masa depan.

Berikut ini adalah kesalahan yang harus Anda hindari:

Mengabaikan kebutuhan penyimpanan cepat seperti SSD NVMe.

Memilih CPU dengan jumlah core yang terlalu sedikit untuk pelatihan ai.

Tidak memeriksa apakah server Anda mendukung beberapa GPU.

Melupakan jaringan berkecepatan tinggi untuk pekerjaan ai terdistribusi.

Mengabaikan kebutuhan pendinginan dan daya.

Catatan: Selalu periksa spesifikasi untuk setiap bagian dari server ai Anda. Pastikan semuanya berfungsi dengan baik.

Sumber Daya untuk Penelitian Lebih Lanjut

Anda dapat terus mendapatkan informasi terbaru tentang perangkat keras server ai dengan mengikuti berita dari perusahaan-perusahaan top. Chip baru sering keluar. Pada awal 2024, Nvidia merilis chip H200, Intel meluncurkan Gaudi3, dan AMD memperkenalkan MI300X. Etched juga membagikan arsitektur baru untuk inferensi ai yang lebih cepat.

Perusahaan | Nama Chip | Deskripsi | Garis Waktu Rilis |

|---|---|---|---|

Nvidia | H200 | Chip AI baru diluncurkan | Q1 2024 |

Intel | Gaudi3 | Chip AI yang bersaing | Q1 2024 |

AMD | MI300X | Chip AI tingkat lanjut | Q1 2024 |

Terukir | N/A | Arsitektur baru untuk inferensi yang lebih cepat | N/A |

Anda dapat bergabung dengan forum online dan membaca blog untuk mempelajari lebih lanjut tentang perangkat keras ai. Banyak ahli berbagi tips dan ulasan. Hal ini membantu Anda membuat pilihan cerdas untuk proyek ai berikutnya.

Anda sekarang tahu cara memilih perangkat keras server yang tepat untuk pekerjaan ai Anda. The NVIDIA DGX Station A100 di Universitas Ostrava sangat kuat. Ini membantu dalam penelitian dan pekerjaan di dunia nyata seperti menemukan cacat dan membuat grafik 3D. Saat Anda memilih perangkat keras, periksa prosesor, memori, penyimpanan, dan jaringan. Berikut ini adalah bagan sederhana:

Komponen | Spesifikasi |

|---|---|

Prosesor | 1x AMD EPYC Genoa 9654 (96c/192t, 2.4GHz) |

Memori | 1152 GB DDR5 |

Penyimpanan | 2x NVMe 960GB + 2x NVMe 3,84TB |

Jaringan | 1x 10Gbit SFP + Intel X710-DA2 (port ganda) |

Untuk membuat server ai Anda lebih baik, cobalah langkah-langkah berikut:

Pilihlah sistem yang dapat berkembang ketika pekerjaan Anda berubah.

Buatlah pengaturan Anda bekerja dengan banyak platform dan jenis.

Menghemat energi dan uang saat Anda membangun server.

Gunakan saluran pipa yang mudah diganti untuk model-model baru.

Teruslah belajar karena perangkat keras menjadi lebih baik. Coba gunakan AI percakapan untuk pelatihan. Gunakan chatbot untuk mempelajari hal-hal baru. Ikuti kuis untuk menguji kemampuan Anda. Hal ini membantu Anda bersiap-siap untuk masa depan AI.

PERTANYAAN YANG SERING DIAJUKAN

Perangkat keras apa yang paling penting untuk server AI?

Anda membutuhkan GPU yang kuat untuk sebagian besar tugas AI. GPU membantu Anda melatih dan menjalankan model jauh lebih cepat daripada CPU. Untuk pembelajaran mendalam, selalu periksa apakah server Anda mendukung GPU NVIDIA atau AMD terbaru.

Berapa banyak RAM yang Anda perlukan untuk beban kerja AI?

Anda harus memulai dengan setidaknya 256GB RAM untuk tugas-tugas AI dasar. Untuk model besar atau pekerjaan pelatihan, gunakan 768GB atau lebih. RAM yang lebih besar membantu Anda bekerja dengan data yang lebih besar dan mencegah perlambatan.

Dapatkah Anda menggunakan server biasa untuk proyek AI?

Anda dapat menggunakan server biasa untuk pekerjaan AI kecil. Untuk pembelajaran mendalam atau model besar, Anda memerlukan Server AI dengan GPU yang lebih baik, lebih banyak memori, dan penyimpanan yang lebih cepat. Server biasa mungkin tidak dapat mengimbangi beban kerja AI yang berat.

Mengapa pendinginan server AI penting?

Server AI menjadi panas saat Anda menjalankan pekerjaan besar. Pendinginan yang baik menjaga perangkat keras Anda aman dan bekerja dengan cepat. Anda dapat menggunakan pendingin cair atau kipas khusus untuk menurunkan suhu dan melindungi investasi Anda.

Apa perbedaan antara perangkat keras pelatihan dan inferensi?

Pelatihan membutuhkan lebih banyak GPU, inti CPU, dan memori. Anda menggunakan perangkat keras ini untuk mengajarkan model Anda. Inferensi menggunakan lebih sedikit sumber daya. Anda menggunakannya untuk membuat prediksi dengan model terlatih Anda. Selalu sesuaikan perangkat keras Anda dengan tugas Anda.