Necesitas un buen hardware para tus proyectos de IA, pero primero debes entender qué es un servidor de IA. Los servidores de IA modernos tienen diferentes requisitos para cada tarea de IA. Por ejemplo, los modelos de ajuste fino necesitan GPUs o TPUs potentes con mucha memoria y redes rápidas. Las cargas de trabajo de inferencia utilizan menos energía y necesitan baja latencia y alto rendimiento, por lo que a menudo dependen de GPU más pequeñas. Cada tarea de IA necesita un hardware especial para funcionar bien, y saber qué es un servidor de IA le ayudará a elegir la configuración adecuada. A la hora de elegir hardware para IA, piense en sus tareas actuales y también planifique el crecimiento futuro de la IA. Para entender realmente qué es un servidor de IA, fíjate en cómo afecta el hardware de IA al rendimiento.

Principales conclusiones

Los servidores de IA necesitan un hardware especial para diferentes trabajos. El entrenamiento requiere GPU potentes y mucha memoria. La inferencia puede realizarse en GPU más pequeñas.

Elija el hardware que se adapte a sus necesidades de IA ahora y más adelante. La escalabilidad te permite actualizar las piezas a medida que tus proyectos crecen.

El almacenamiento rápido, como las SSD NVMe, es muy importante para el trabajo de IA. Ayuda a cargar los datos con rapidez y mantiene el buen funcionamiento de los modelos.

La velocidad de la red es importante para el rendimiento de la IA. Se necesita un gran ancho de banda para mover los datos entre los servidores y las GPU. Esto es especialmente importante en la formación distribuida.

Trate de no hacer errores comunes al elegir hardware de IA. Asegúrate de tener suficiente memoria, buena refrigeración y las GPU adecuadas para tus trabajos.

¿Qué es un servidor de IA?

Te preguntarás qué es un servidor ai y en qué se diferencia de los servidores normales. Un servidor de Inteligencia Artificial es un ordenador diseñado para realizar tareas de Inteligencia Artificial. Estas tareas incluyen entrenar modelos, ejecutar inferencias y trabajar con muchos datos. El uso de un servidor de Inteligencia Artificial te proporciona un hardware que realiza cálculos rápidos y tiene mucha memoria. Muchas empresas utilizan un servidor especial para sus proyectos más complejos.

Servidor de IA frente a servidor tradicional

Te preguntarás qué es un servidor ai comparado con un servidor normal. Un servidor normal hace cosas sencillas como guardar archivos o alojar sitios web. Utiliza CPUs normales y memoria básica. Un servidor AI tiene mejor hardware. A menudo se ven GPUs potentes, más RAM y almacenamiento más rápido. Estas cosas te ayudan a ejecutar trabajos de ai mucho más rápido.

He aquí una sencilla tabla que muestra las diferencias:

Característica | Servidor tradicional | Servidor AI |

|---|---|---|

CPU | Estándar | Alto rendimiento |

GPU | Ninguno o básico | Avanzado, múltiple |

RAM | Moderado | Gran capacidad |

Almacenamiento | DISCO DURO/SSD | SSD NVMe |

Caso práctico | General | Cargas de trabajo de IA |

Características principales de los servidores AI

Cuando miras lo que es un servidor ai, ves cosas especiales. Tiene soporte para muchas GPU, que ayudan con el aprendizaje profundo y otros trabajos de IA. También encontrarás redes rápidas, que mueven datos rápidamente entre ordenadores. La gran memoria te permite entrenar modelos más grandes. El almacenamiento rápido, como las SSD NVMe, te ayuda a cargar datos rápidamente.

Consejo: Si quieres ampliar tus proyectos de Inteligencia Artificial, elige un servidor que puedas actualizar. Esto te ayudará a mantenerte al día con las nuevas herramientas de AI.

Ahora ya sabes qué es un servidor de ai y por qué es importante para los trabajos modernos. Puedes elegir el mejor hardware para tus necesidades y obtener mejores resultados de tus proyectos de ai.

Exigencias de la carga de trabajo de la IA

Formación, inferencia y tareas en tiempo real

Verás que las diferentes cargas de trabajo de la IA necesitan hardware diferente. El entrenamiento es el proceso en el que se enseña un modelo de IA utilizando muchos datos. Este paso es el que más recursos consume. Necesitas GPUs y CPUs potentes para gestionar el entrenamiento. La inferencia consiste en utilizar el modelo de Inteligencia Artificial entrenado para realizar predicciones. Esta tarea consume menos energía que el entrenamiento, pero sigue necesitando tiempos de respuesta rápidos. Las cargas de trabajo de IA en tiempo real, como control por voz o la navegación de drones, necesitan tanto velocidad como precisión. Estas tareas deben procesar los datos con rapidez para ofrecer resultados instantáneos.

Algunas de las cargas de trabajo ai más exigentes son:

Búsqueda de palabras clave

Control por voz

Tratamiento de audio e imágenes

Concentradores de sensores

Navegación y control de drones

Realidad aumentada

Realidad virtual

Equipos de comunicaciones

Necesitas hardware eficiente para manejar estas cargas de trabajo ai. La computación de alto rendimiento y el procesamiento SIMD ayudan a ejecutar estas tareas sin problemas. A medida que crezca la Inteligencia Artificial, aparecerán más aplicaciones que necesitarán hardware avanzado.

Nota: Jack Dongarra, galardonado con el premio Turing, dice la ai ya da forma a la mayoría de las aplicaciones. Dependerá más del hardware avanzado a medida que las cargas de trabajo ai sean más comunes.

Proceso de datos y necesidades energéticas

Las modernas cargas de trabajo de TI mueven enormes cantidades de datos. Se necesita un almacenamiento rápido y una red potente para mantener el ritmo. Tanto el entrenamiento como la inferencia utilizan grandes conjuntos de datos. Las cargas de trabajo de la Inteligencia Artificial en tiempo real deben procesar los datos sin demora. Esto significa que su servidor debe manejar un alto rendimiento de datos.

Las necesidades energéticas de las cargas de trabajo de la Inteligencia Artificial también están aumentando. Algunos servidores de IA utilizan casi un megavatio de potencia por bastidor. Los nuevos sistemas de alimentación de 800 V CC pueden soportar hasta 1,2 MW por bastidor. Los sistemas antiguos de 54 V no pueden satisfacer esta demanda. Debe planificar mayores necesidades de potencia y refrigeración al configurar los servidores ai.

Si quieres que tus cargas de trabajo de ai funcionen bien, debes adecuar tu hardware a tus necesidades de datos y energía. Esto te ayudará a obtener los mejores resultados de tus proyectos de IA.

Requisitos de hardware para la IA

Cuando cree o cambie su servidor de IA, debe conocer las principales necesidades de hardware. Estas necesidades le ayudarán a ejecutar modelos de aprendizaje profundo y a trabajar con big data. Un buen hardware garantiza que tus tareas de IA funcionen bien y rápido. Veamos las principales piezas que necesitas para los trabajos de IA actuales.

Requisitos de la CPU

La CPU es como el cerebro de tu servidor de IA. Necesitas una CPU potente para preparar los datos, gestionar la memoria y ayudar a las GPU a trabajar juntas. Para la IA, elige CPU con muchos núcleos y alta velocidad. Intel Xeon y AMD EPYC son opciones populares. Estas CPU ayudan con el aprendizaje profundo y los trabajos de big data.

Muchos servidores necesitan 12 o más CPU para trabajar con IA. Las CPU realizan tareas difíciles que las GPU no pueden hacer solas. Por ejemplo, las CPU cargan datos, ejecutan modelos antiguos de aprendizaje automático y mueven información entre las distintas partes. Cuando elijas una CPU, asegúrate de que se ajusta a tus necesidades de memoria y GPU.

Consejo: Para el aprendizaje profundo, elige CPUs con al menos 16 núcleos y memoria rápida. Esto evita ralentizaciones al entrenar o utilizar modelos de IA.

Tipo de hardware | Descripción | Rendimiento de las tareas de IA |

|---|---|---|

CPU | 4-16 trabajadores muy inteligentes y polivalentes | Maneja tareas complejas de forma secuencial |

GPU | 1.000-10.000 trabajadores especializados | Puede ser entre 10 y 100 veces más rápido gracias al procesamiento paralelo de operaciones matemáticas sencillas. |

Requisitos de la GPU

Las GPU son la parte más importante de la IA. Se necesitan GPU potentes para entrenar modelos de aprendizaje profundo y ejecutar tareas con rapidez. Las GPU modernas tienen miles de núcleos que funcionan al mismo tiempo. Esto las hace mucho más rápidas que las CPU para los trabajos de IA.

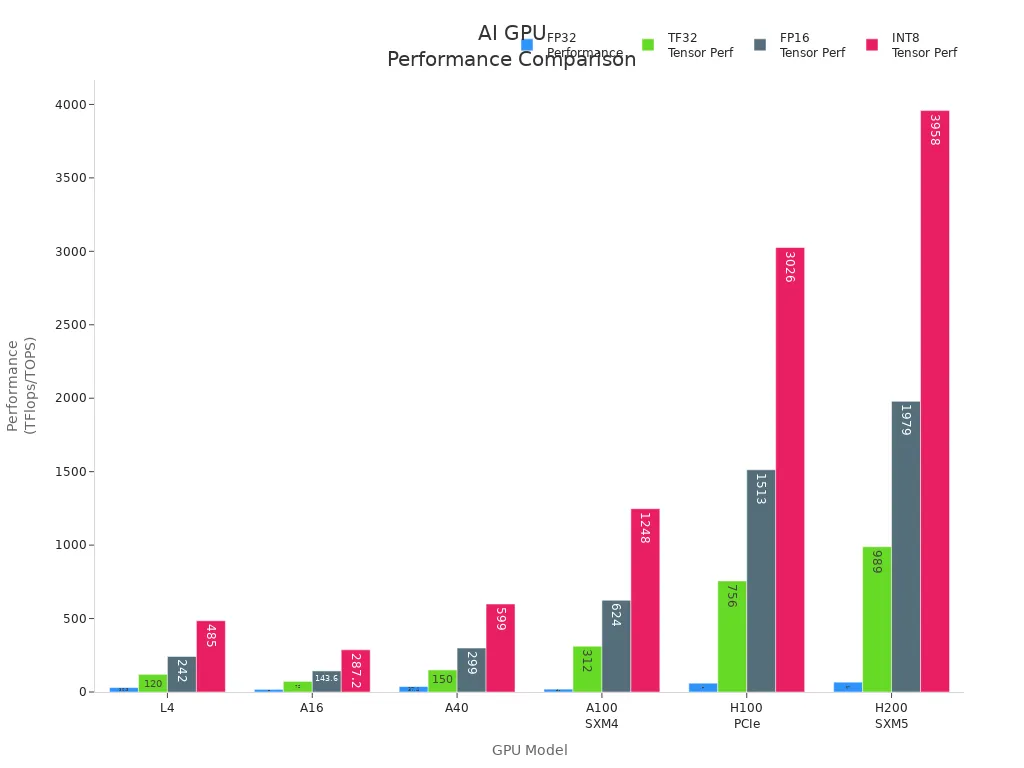

Cuando elijas GPU, busca modelos como NVIDIA A100, H100, V100 y L4. Estas GPU tienen mucha memoria, gran velocidad y un gran rendimiento para la IA. La siguiente tabla muestra algunas de las mejores GPU para entrenar y utilizar la IA:

Modelo GPU | Núcleos CUDA | Núcleos tensores | Memoria GPU | Rendimiento de la memoria | FP32 (TFlops) | Tensor TF32 (TFlops) | FP16 Tensor (TFlops) | Tensor INT8 (TOPS) |

|---|---|---|---|---|---|---|---|---|

L4 | 7,680 | 240 | 24 GB | 300 GB/s | 30.3 | 120* | 242* | 485* |

A16 | 4x 1,280 | 4x 40 | 4x 16 GB | 4x 200 GB/s | 4x 4.5 | 4x 18* | 4x 35.9* | 4x 71.8* |

A40 | 10,752 | 336 | 48 GB | 696 GB/s | 37.4 | 150* | 299* | 599* |

A100 SXM4 | 19,500 | 432 | 80 GB | 1.935 GB/s | 19.5 | 312* | 624* | 1,248* |

H100 PCIe | 60,000 | 528 | 80 GB | 2 TB/s | 60 | 756* | 1,513* | 3,026* |

H200 SXM5 | 72,000 | 528 | 141 GB | 3,3 TB/s | 67 | 989* | 1,979* | 3,958* |

Necesitas más de una GPU para grandes modelos de IA y aprendizaje profundo. Algunos servidores pueden utilizar hasta ocho GPU. Esto permite entrenar modelos más grandes y trabajar con más datos a la vez. Las GPU también ayudan con trabajos de IA en tiempo real, como tareas de imagen y voz.

Nota: las GPU pueden ser entre 10 y 100 veces más rápidas que las CPU para el aprendizaje profundo. Elige siempre GPU que se adapten a tus necesidades de IA y al tamaño del modelo.

RAM y memoria

La memoria RAM es una parte clave del hardware de IA. Necesitas memoria suficiente para cargar big data y ejecutar modelos de aprendizaje profundo. Si no tienes suficiente RAM, tus trabajos de IA serán lentos o no funcionarán.

Para el aprendizaje profundo, empieza con al menos 768 GB de RAM DDR4 a 2667 MHz. Esta cantidad ayuda con los modelos grandes y el trabajo con datos rápidos. Más RAM te permite entrenar modelos más grandes y realizar tareas de IA más complejas. A medida que tus modelos y datos crezcan, necesitarás más memoria.

Se necesita mucha memoria para el aprendizaje profundo.

Más RAM detiene las ralentizaciones durante el entrenamiento.

Una memoria rápida ayuda a que los trabajos de IA funcionen mejor.

Consejo: Comprueba siempre las necesidades de memoria de tu modelo de IA antes del entrenamiento. Añade más RAM si utilizas modelos más grandes o más datos.

Soluciones de almacenamiento

Los trabajos de IA necesitan un almacenamiento rápido y potente. Elija un almacenamiento capaz de almacenar grandes volúmenes de datos y ofrecer un acceso rápido para el aprendizaje profundo. Las SSD NVMe son las mejores para la mayoría de las necesidades de IA. Son rápidos y responden con rapidez.

He aquí una tabla de las mejores opciones de almacenamiento para la IA:

Solución de almacenamiento | IOPS (operaciones de entrada/salida por segundo) | Tiempo de respuesta | Disponibilidad de datos | Capacidad de almacenamiento |

|---|---|---|---|---|

Almacenamiento HPE 3PAR StoreServ 8450 | Hasta 3 millones | < 1 ms | 99.9999% | Hasta 80 PB |

SSD NVMe de 30 TB | Alta velocidad | N/A | N/A | N/A |

Necesitas un almacenamiento que se adapte a la velocidad de tu GPU y CPU. Un almacenamiento rápido ayuda a cargar los datos con rapidez y mantiene el buen funcionamiento de los modelos de IA. Para trabajos de IA de gran envergadura, utiliza un almacenamiento con IOPS altas y tiempos de espera bajos.

Necesidades de red

Las redes son muy importantes para el hardware de IA. Se necesita un gran ancho de banda para mover datos entre servidores, GPU y almacenamiento. El entrenamiento distribuido de IA necesita redes rápidas y potentes para que todo funcione a la vez.

Los servidores de GPU ofrecen un gran ancho de banda y flexibilidad para el entrenamiento distribuido de IA.

Se necesita una red de al menos 100 Gb para los grandes trabajos de IA.

Las agrupaciones cercanas a tu equipo te ayudan con los datos y el rendimiento.

Característica | Descripción |

|---|---|

Tipo de servidor | Los servidores GPU proporcionan un gran ancho de banda y flexibilidad para el entrenamiento distribuido de IA. |

Aceleración de la carga de trabajo | Ideal para entrenar grandes modelos lingüísticos y realizar análisis de big data. |

Rendimiento | Garantiza un rendimiento óptimo y una alta fiabilidad para diversas aplicaciones. |

Nota: Adapta siempre la velocidad de tu red a las necesidades de hardware de tu IA. Una red lenta puede hacer que los modelos de aprendizaje profundo y los trabajos de IA tarden más.

Hardware de uso general frente a hardware especializado en IA

Puedes elegir CPU generales o hardware de IA especial como TPU y FPGA. Las CPU realizan muchas tareas, pero las GPU, TPU y FPGA funcionan mucho más rápido para el aprendizaje profundo.

CPUs: Buenas para preparar datos y modelos antiguos.

GPUs: Lo mejor para el aprendizaje profundo y trabajar en muchas cosas a la vez.

TPUs: Hechas para trabajos de IA, especialmente aprendizaje profundo.

FPGAs: Flexibles y buenos para trabajos de IA personalizados.

El hardware especial de IA, como las TPU y las FPGA, puede hacer que los trabajos sean más rápidos y consuman menos energía. Deberías pensar en ellos si tus tareas de IA necesitan más velocidad o mayor eficiencia.

Consejo: Comprueba siempre tus necesidades de hardware de IA antes de elegir hardware general o especial. La mejor elección depende de tus modelos, datos y de la velocidad a la que necesites trabajar.

Conociendo estas necesidades principales de hardware de IA, puedes construir un servidor que se adapte a tus trabajos de aprendizaje profundo e IA. Un buen hardware te ayuda a entrenar modelos más grandes, utilizar más datos y obtener mejores resultados en todas tus tareas de IA.

Especificaciones de hardware mínimas y recomendadas

Elegir el hardware adecuado ayuda a que tus modelos de ai funcionen bien. Necesitas adaptar tu hardware a tus tareas de AI. Cada trabajo necesita diferentes cpu, gpu, memoria, ram y almacenamiento. Aquí tienes reglas sencillas para el entrenamiento, la inferencia y la Inteligencia Artificial en tiempo real.

Para la formación en IA

La formación de modelos de Inteligencia Artificial requiere muchos recursos. Se necesita un hardware potente para grandes conjuntos de datos y modelos complejos. La configuración correcta te permite entrenar más rápido y hacer trabajos de Inteligencia Artificial más grandes.

Requisitos mínimos para la formación ai:

CPU: 16 núcleos (Intel Xeon o AMD EPYC)

gpu: 1 NVIDIA A100 o V100

ram: 256 GB DDR4

Memoria: 256 GB o más

almacenamiento: SSD NVMe de 2 TB

Red: 25 Gbps

Requisitos recomendados para la formación ai:

cpu: 32+ núcleos (Intel Xeon o AMD EPYC más recientes)

gpu: 4-8 NVIDIA H100 o A100

ram: 768 GB DDR4 o superior

Memoria: 768 GB o más

almacenamiento: 8 TB+ SSD NVMe

Red: 100 Gbps o superior

Consejo: Más potencia de gpu y ram te ayudan a entrenar modelos más grandes. Terminarás los trabajos de ai más rápido. Comprueba siempre el tamaño de tu modelo antes de entrenar.

Necesitas tarjetas gpu potentes porque hacen muchas tareas a la vez. Más ram y memoria para cargar rápidamente grandes conjuntos de datos. El almacenamiento rápido mantiene los datos en movimiento durante el entrenamiento.

Para la inferencia de IA

La inferencia utiliza modelos entrenados para hacer predicciones. Necesitas un hardware que ofrezca resultados rápidos y gestione muchas peticiones. La configuración adecuada te ayuda a obtener un buen rendimiento y un bajo retardo en tus trabajos de ai.

Requisitos mínimos para la inferencia de ai:

CPU: 8 núcleos (Intel Xeon o AMD EPYC)

gpu: 1 NVIDIA L4 o A16

ram: 64 GB DDR4

memoria: 64 GB o más

almacenamiento: SSD NVMe de 1 TB

Redes: 10 Gbps

Requisitos recomendados para la inferencia de ai:

Memoria | Caso práctico | |

|---|---|---|

NVIDIA B200 | 180 GB | Cargas de trabajo de alta memoria |

NVIDIA DGX B200 | 1440 GB | Grandes LLM de código abierto |

Nodo multi-GPU | N/A | Inferencia distribuida |

cpu: 16+ núcleos (Intel Xeon o AMD EPYC más recientes)

gpu: NVIDIA B200 o DGX B200 (para modelos grandes)

ram: 256 GB DDR4 o superior

Memoria: 256 GB o más

almacenamiento: SSD NVMe de 4 TB

Red: 25 Gbps o superior

Nota: La inferencia en cpu es lenta. Puede que sólo obtengas unos pocos caracteres cada pocos segundos. Las tarjetas gpu modernas pueden darte más de 100 caracteres por segundo. Para obtener mejores resultados, mantenga los pesos de todo su modelo en la memoria de la gpu.

Se obtienen mejores resultados con un nodo multi-gpu para la inferencia. Esta configuración reduce los retrasos y simplifica las tareas de Inteligencia Artificial. Usar muchos nodos para la inferencia puede ralentizarte y costarte más.

Para la IA en tiempo real

Los trabajos de ai en tiempo real necesitan respuestas instantáneas. Debes utilizar hardware que ofrezca alta velocidad y bajo retardo. Estas reglas te ayudarán a ejecutar modelos de Inteligencia Artificial para control por voz, navegación de drones y realidad aumentada.

Requisitos mínimos para la ai en tiempo real:

CPU: 8 núcleos (Intel Xeon o AMD EPYC)

gpu: 1 NVIDIA L4 o A16

ram: 64 GB DDR4

memoria: 64 GB o más

almacenamiento: SSD NVMe de 1 TB

Redes: 10 Gbps

Requisitos recomendados para ai en tiempo real:

cpu: 16+ núcleos (Intel Xeon o AMD EPYC más recientes)

gpu: 2-4 NVIDIA A100 o H100

ram: 256 GB DDR4 o superior

Memoria: 256 GB o más

almacenamiento: SSD NVMe de 2 TB

Red: 25 Gbps o superior

Consejo: La Inteligencia Artificial en tiempo real necesita tarjetas gráficas rápidas y suficiente memoria RAM. Prueba siempre tu hardware con tus trabajos de Inteligencia Artificial real antes de lanzarlos.

Debes equilibrar cpu, gpu, memoria y almacenamiento para obtener los mejores resultados. Una red rápida ayuda a que tus trabajos de ai funcionen sin problemas, especialmente con muchas tarjetas gpu.

Si sigues estas reglas, puedes construir un servidor de Inteligencia Artificial para entrenamiento, inferencia y Inteligencia Artificial en tiempo real. El hardware adecuado te proporciona mayor velocidad, resultados más rápidos y modelos de IA más fiables.

Comparación de los requisitos de hardware de IA por tarea

Formación frente a inferencia

Tienes que entender cómo cambios en el hardware cuando se cambia entre entrenamiento e inferencia para modelos ai. El entrenamiento pone al servidor al límite. Se utilizan muchas tarjetas gpu, a menudo ocho o más, como la NVIDIA H100, para manejar enormes cantidades de datos. La cpu debe tener muchos núcleos para seguir el ritmo de la gpu y mover los datos con rapidez. La formación también necesita mucha memoria. Se necesita un gran ancho de banda de memoria para que los modelos no se ralenticen.

La inferencia funciona de otra manera. Se utilizan menos tarjetas gpu, a veces sólo una o dos. Se puede ejecutar la inferencia en una cpu, pero se obtiene un rendimiento mucho mayor con una gpu. La CPU no necesita tantos núcleos para la inferencia. Sigue necesitando un buen rendimiento, pero el hardware no trabaja tanto como durante el entrenamiento. La memoria es importante, pero no se necesita tanta como para el entrenamiento.

He aquí una rápida comparación:

Tarea | Se necesita GPU | CPU necesaria | Memoria necesaria | Rendimiento |

|---|---|---|---|---|

Formación | Muchos núcleos | Muy alta | Velocidad máxima | |

Inferencia | 1-4 tarjetas o CPU | Menos núcleos | Moderado | Respuesta rápida |

Consejo: Si quieres entrenar modelos de Inteligencia Artificial de gran tamaño, invierte en más tarjetas gpu y alta memoria. Para la inferencia, céntrate en un rendimiento rápido con menos tarjetas gpu.

Procesamiento en tiempo real frente a procesamiento por lotes

Las tareas de ai en tiempo real necesitan respuestas instantáneas. Se utiliza un hardware que ofrezca un rendimiento rápido y un retardo bajo. La gpu debe procesar los datos rápidamente. La cpu ayuda a mover los datos sin esperas. Se necesita memoria suficiente para que los modelos funcionen sin problemas. Las tareas en tiempo real incluyen el control por voz y la navegación de drones.

El procesamiento por lotes trabaja con grandes grupos de datos a la vez. No se necesitan resultados instantáneos. Puedes utilizar más núcleos de cpu y tarjetas gpu para terminar grandes trabajos a lo largo del tiempo. El rendimiento es importante, pero puedes esperar más tiempo para obtener resultados. Necesitas memoria suficiente para manejar todos tus modelos y datos.

En tiempo real: Gpu rápida, cpu rápida, bajo retardo, rendimiento estable.

Lote: Más tarjetas gpu, más núcleos cpu, más memoria, más tiempo de procesamiento.

Nota: Elige tu hardware en función de tu tarea ai. Los trabajos en tiempo real necesitan velocidad. Los trabajos por lotes necesitan potencia y memoria.

Optimizar y preparar para el futuro el hardware de los servidores de IA

Escalabilidad y actualizaciones

Quieres que tu servidor ai crezca a medida que cambien tus necesidades. Escalabilidad significa que puedes añadir más potencia más adelante. Puedes empezar con unas pocas GPUs y añadir más cuando tus modelos crezcan. Muchos servidores permiten actualizar las CPU, la memoria y el almacenamiento. De este modo, el hardware está preparado para nuevos trabajos de ai. Cuando planifiques actualizaciones, comprueba si puedes añadir TPUs o más GPUs fácilmente. Algunos servidores de Inteligencia Artificial pueden utilizar hasta ocho GPUs o TPUs. Esto te ayuda a entrenar modelos más rápidamente. Deberías comprobar si tu servidor puede manejar más memoria y redes más rápidas. Escalabilidad significa que no necesitas un nuevo servidor cada vez que tu trabajo de Inteligencia Artificial crece.

Energía y refrigeración

Los servidores ai de alto rendimiento consumen mucha energía. Se necesita buena refrigeración para mantener a salvo tu hardware. Hay distintas formas de refrigerar los servidores ai. La refrigeración directa al chip coloca placas frías en las CPU y GPU. Esto ayuda a controlar mejor el calor. Los sistemas líquido-aire funcionan para trabajos de ai medios, pero puede que no se adapten a configuraciones abarrotadas. La refrigeración por inmersión sumerge los servidores en fluidos especiales para evacuar el calor. La refrigeración por inmersión bifásica utiliza fluidos en ebullición y condensación para obtener los mejores resultados. Cada método de refrigeración tiene sus ventajas y sus inconvenientes. Puedes ver las diferencias en la siguiente tabla:

Método de refrigeración | Descripción | Ventajas | Limitaciones |

|---|---|---|---|

Sistemas líquido-aire | Circuito cerrado de refrigerante en el interior del bastidor, desplaza el calor al aire. | Fácil de montar, buena para trabajos medios. | No es bueno para servidores muy ocupados, no es fácil de cultivar. |

Refrigeración directa al chip | Las placas frías tocan las CPU/GPU para un mejor control del calor. | Funciona bien, mejor para servidores potentes. | Necesita más tuberías y configuración. |

Refrigeración por inmersión monofásica | Los servidores se asientan en un fluido especial para una transferencia uniforme del calor. | Gran control del calor, silencioso, no necesita ventiladores de servidor. | Necesita hardware especial, ocupa más espacio. |

Refrigeración bifásica por inmersión | Utiliza fluidos en ebullición y condensación para desplazar el calor. | Muy bueno para enfriar, casi siempre funciona solo. | Los fluidos cuestan mucho, son difíciles de montar y cuidar. |

Elige un método de refrigeración que se adapte al tamaño de tu servidor ai y a lo ocupado que esté. Una buena refrigeración hace que tus TPU y GPU funcionen con rapidez.

Prepararse para las necesidades futuras de la IA

Debes planificar con antelación la construcción de tu servidor de Inteligencia Artificial. Las TPU y las FPGA se utilizan más para el aprendizaje profundo ahora. Las TPU funcionan rápido y consumen menos energía para el entrenamiento. Las FPGA te permiten cambiar tu hardware para trabajos especiales de ai. Puedes utilizar TPUs, GPUs y CPUs juntas para obtener mejores resultados. Los nuevos modelos de Inteligencia Artificial necesitan más memoria y redes más rápidas. Elige servidores que te permitan actualizarlos más adelante. De este modo, podrás añadir más TPUs o memoria a medida que crezcan tus proyectos de Inteligencia Artificial. Planificar para el futuro te ayuda a estar preparado para nuevas herramientas y trabajos de mayor envergadura.

Consejo: Prueba siempre tu hardware ai con trabajos reales antes de actualizarlo. Esto te ayudará a encontrar la mejor combinación de TPU, GPU y CPU para tu trabajo.

Consejos prácticos para elegir el hardware del servidor de IA

Evalúe sus necesidades

Tienes que empezar por analizar tu carga de trabajo ai. Piensa en el tamaño de tus datos y en la velocidad que quieres. Si entrenas modelos de gran tamaño, necesitarás GPU potentes y mucha memoria. Para tareas de Inteligencia Artificial sencillas, puedes utilizar menos recursos. Escribe tus objetivos y los tipos de proyectos de IA que piensas ejecutar. Esto te ayudará a elegir el hardware que mejor se adapte a tus necesidades.

Enumere sus principales tareas ai.

Compruebe si necesita resultados en tiempo real o procesamiento por lotes.

Calcule cuántos datos utilizará cada mes.

Decida si desea actualizar su servidor en el futuro.

Consejo: Pruebe primero sus modelos ai en hardware pequeño. Así podrás ver qué funciona mejor antes de comprar servidores más grandes.

Evitar errores comunes

Mucha gente comete errores al elegir el hardware de un servidor ai. Puede que compre muy poca memoria o elija una GPU que no se ajuste a su carga de trabajo. Algunos se olvidan de las necesidades de refrigeración y alimentación. Otros no planifican el futuro crecimiento de la IA.

Estos son los errores que debe evitar:

Ignorando la necesidad de almacenamiento rápido como las SSD NVMe.

Elección de CPU con muy pocos núcleos para el entrenamiento ai.

No comprobar si su servidor soporta múltiples GPUs.

Olvídate de las redes de alta velocidad para los trabajos de ai distribuidos.

Pasar por alto los requisitos de refrigeración y alimentación.

Nota: Comprueba siempre las especificaciones de cada parte de tu servidor ai. Asegúrate de que todo funciona correctamente.

Recursos para seguir investigando

Puede mantenerse al día sobre hardware de servidor ai siguiendo las noticias de las principales empresas. Los nuevos chips salen a menudo. A principios de 2024, Nvidia lanza el chip H200, Intel lanzó Gaudi3 y AMD presentó MI300X. Etched también compartió una nueva arquitectura para una inferencia de ai más rápida.

Empresa | Nombre del chip | Descripción | Calendario de publicación |

|---|---|---|---|

Nvidia | H200 | Nuevo chip de inteligencia artificial | Q1 2024 |

Intel | Gaudí3 | Chip de IA competidor | Q1 2024 |

AMD | MI300X | Chip de IA avanzada | Q1 2024 |

Grabado | N/A | Nueva arquitectura para una inferencia más rápida | N/A |

Puedes unirte a foros en línea y leer blogs para aprender más sobre el hardware de ai. Muchos expertos comparten consejos y opiniones. Esto te ayudará a tomar decisiones inteligentes para tu próximo proyecto de Inteligencia Artificial.

Ahora ya sabe cómo elegir el hardware de servidor adecuado para sus trabajos de ai. En NVIDIA DGX Station A100 de la Universidad de Ostrava es muy potente. Ayuda en la investigación y en trabajos del mundo real como encontrar defectos y hacer gráficos en 3D. Cuando elijas hardware, comprueba el procesador, la memoria, el almacenamiento y la red. Aquí tienes un gráfico sencillo:

Componente | Especificación |

|---|---|

Procesador | 1x AMD EPYC Genoa 9654 (96c/192t, 2,4 GHz) |

Memoria | 1152 GB DDR5 |

Almacenamiento | 2x 960 GB NVMe + 2x 3,84 TB NVMe |

Red | 1x 10Gbit SFP+ Intel X710-DA2 (doble puerto) |

Para mejorar tu servidor ai, prueba estos pasos:

Elige sistemas que puedan crecer cuando cambie tu trabajo.

Haz que tu configuración funcione con muchas plataformas y tipos.

Ahorre energía y dinero cuando construya su servidor.

Utilice conductos que sean fáciles de cambiar para nuevos modelos.

Siga aprendiendo a medida que mejora el hardware. Pruebe a utilizar la IA conversacional para entrenarse. Utiliza chatbots para aprender cosas nuevas. Haz cuestionarios para poner a prueba tus conocimientos. Esto te ayudará a prepararte para el futuro de la IA.

PREGUNTAS FRECUENTES

¿Cuál es el hardware más importante para los servidores de IA?

Para la mayoría de las tareas de IA se necesitan GPU potentes. Las GPU te ayudan a entrenar y ejecutar modelos mucho más rápido que las CPU. Para el aprendizaje profundo, comprueba siempre si tu servidor es compatible con las últimas GPU de NVIDIA o AMD.

¿Cuánta RAM necesitas para las cargas de trabajo de IA?

Deberías empezar con al menos 256 GB de RAM para tareas básicas de IA. Para modelos grandes o trabajos de formación, utilice 768 GB o más. Más RAM te ayuda a trabajar con datos más grandes y evita ralentizaciones.

¿Se pueden utilizar servidores normales para proyectos de IA?

Puedes utilizar servidores normales para pequeños trabajos de IA. Para el aprendizaje profundo o modelos grandes, necesita Servidores de IA con mejores GPU, más memoria y un almacenamiento más rápido. Los servidores normales pueden no estar a la altura de las grandes cargas de trabajo de IA.

¿Por qué es importante la refrigeración de los servidores AI?

Los servidores de IA se calientan cuando se ejecutan grandes trabajos. Una buena refrigeración mantiene el hardware seguro y funcionando con rapidez. Puede utilizar refrigeración líquida o ventiladores especiales para bajar la temperatura y proteger su inversión.

¿Cuál es la diferencia entre el hardware de entrenamiento y el de inferencia?

El entrenamiento necesita más GPU, núcleos de CPU y memoria. Este hardware se utiliza para enseñar el modelo. La inferencia utiliza menos recursos. Se utiliza para hacer predicciones con el modelo entrenado. Adapte siempre el hardware a la tarea.